Última atualização: Janeiro 2026

Um funcionário de finanças em Hong Kong se juntou a uma chamada de vídeo que parecia ser de rotina com o CFO e vários colegas para finalizar os detalhes de uma aquisição confidencial. Após uma discussão aparentemente legítima, o funcionário autorizou transferências bancárias de $25,6 milhões. Todas as pessoas naquela chamada — exceto a vítima — eram deepfakes.

Este ataque à empresa de engenharia Arup não foi um caso isolado. Foi um tiro de advertência. E em 2026, incidentes como esse não serão chocantes — serão esperados, a menos que as organizações repensem fundamentalmente como a confiança é estabelecida em um mundo onde ver não é mais acreditar.

Resumo

As perdas com fraudes habilitadas por deepfake ultrapassaram $200 milhões globalmente apenas no primeiro trimestre de 2025, uma cifra que provavelmente representa apenas uma fração do impacto total devido à subnotificação.

A fraude de identidade sintética agora é um dreno anual de $30–35 bilhões, com a maioria das perdas ocultadas dentro de "perdas de crédito" em vez de sinalizadas como fraude, permitindo que identidades fabricadas persistam indetectadas até o inadimplemento.

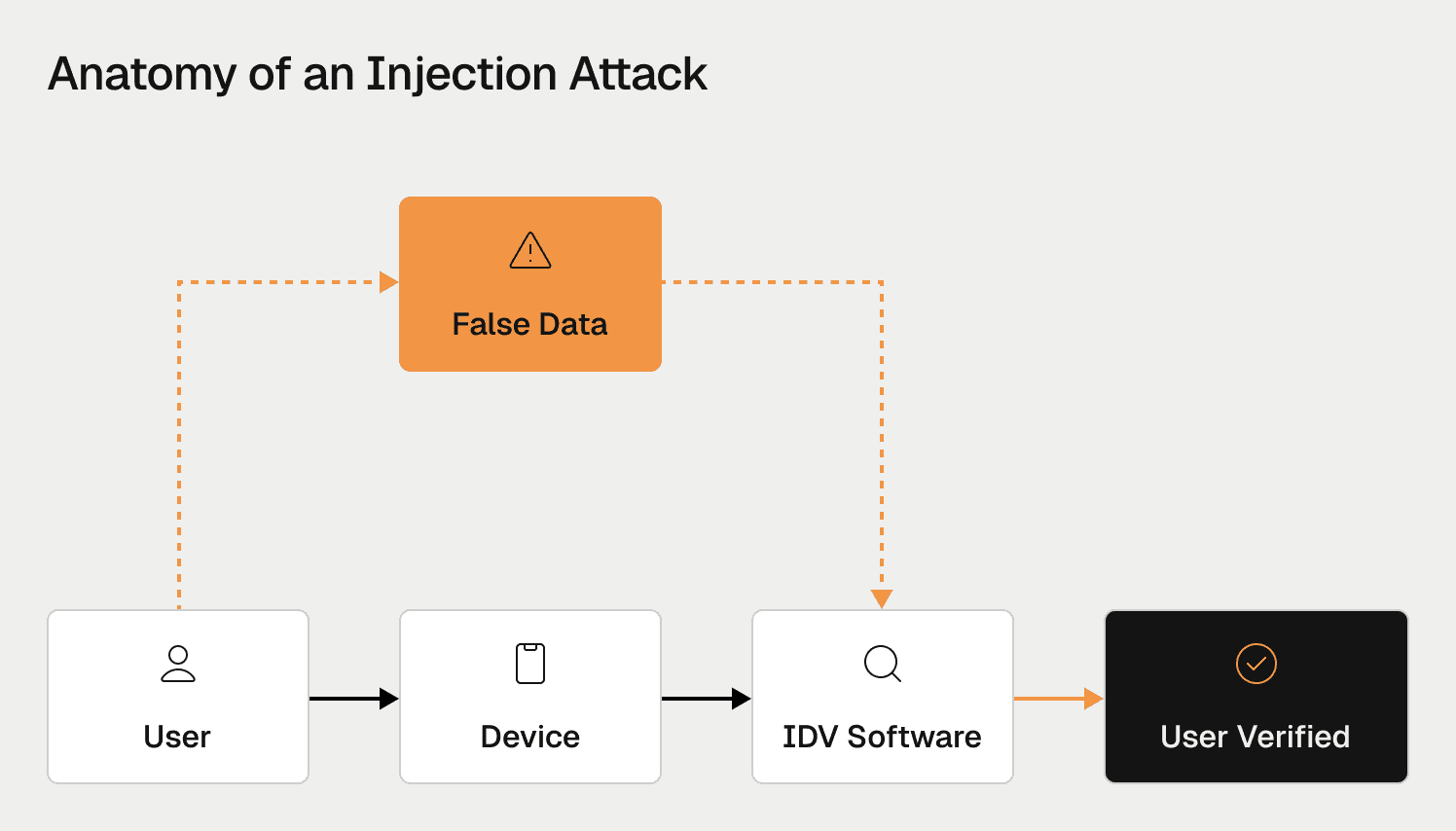

Os invasores usam ataques de injeção para contornar a verificação de vídeo ao alimentar deepfakes diretamente em fluxos de dados, derrotando completamente a detecção de vivacidade tradicional.

Prevê-se que a fraude habilitada por IA atinja $40 bilhões anualmente nos EUA até 2027 (CAGR de ~30%), com a Experian chamando 2026 de ponto de inflexão, já que 72% dos líderes empresariais agora classificam a fraude habilitada por IA como um dos principais desafios operacionais.

A defesa eficaz requer inteligência unificada que correlaciona sinais de identidade, dispositivo, comportamento e transação em tempo real.

Quão grande é o problema de fraude de deepfake em 2026?

Os números publicados não capturam a escala real do problema. Fraudes habilitadas por deepfake raramente são rotuladas como tal nos relatórios financeiros — em vez disso, as perdas são absorvidas em categorias mais amplas, como fraude de pagamento autorizado, fraude de apropriação de conta ou inadimplências de crédito. O que vemos nos números oficiais representa apenas incidentes verificados e atribuídos, não o impacto real.

Ainda assim, mesmo com a subnotificação sistemática, a aceleração é inconfundível. O Fórum Econômico Mundial relata mais de $200 milhões em perdas confirmadas relacionadas a fraudes de deepfake apenas no primeiro trimestre de 2025, descrevendo a tendência como uma mudança fundamental em direção a ataques diretos e escaláveis a operações comerciais.

O Centro de Serviços Financeiros da Deloitte projeta que a fraude habilitada por IA pode chegar a $40 bilhões anualmente nos Estados Unidos até 2027 — uma taxa de crescimento anual composta de aproximadamente 30%. Essa projeção abrange deepfakes, identidades sintéticas, engenharia social automatizada e apropriação de contas conduzida por IA, ilustrando como os deepfakes agora funcionam como um componente em um conjunto mais amplo de fraudes habilitadas por IA.

Dados de detecção mostram uma velocidade semelhante. A Signicat relata que as tentativas de fraude de deepfake aumentaram em mais de 2.000% nos últimos três anos, impulsionadas por mercados de fraude como serviço e modelos generativos em rápida melhoria. A previsão do Futuro da Fraude de 2026 da Experian chama este ano de um claro "ponto de inflexão", com 72% dos líderes empresariais identificando a fraude habilitada por IA como um dos principais desafios operacionais.

As barreiras técnicas continuam a desmoronar. Como detalhamos em um artigo anterior, a clonagem de voz agora requer apenas 20-30 segundos de áudio, enquanto deepfakes de vídeo convincentes podem ser gerados em 45 minutos — tornando a fraude de alto impacto mais barata, rápida e muito mais escalável do que os ataques de identidade tradicionais.

O que torna os ataques de deepfake tão eficazes contra bancos?

A ameaça vem tanto dos sistemas de entrega quanto dos próprios falsos. Invasores modernos contornam a verificação de identidade usando ataques de injeção, onde vídeos sintéticos são alimentados diretamente em fluxos de dados por meio de software de câmera virtual ou emuladores móveis. O aplicativo do banco acredita que está recebendo um feed de câmera ao vivo quando, na verdade, está processando uma fabricação digital. Esses ataques derrotam a detecção de vivacidade por completo, funcionando contra tanto verificações passivas quanto muitas soluções de vivacidade ativa (como virar a cabeça ou piscar) quando esses desafios não têm verdadeira aleatoriedade.

Ao mesmo tempo, a fraude habilitada por deepfake está se expandindo através do aumento da fraude como serviço. Grupos organizados agora vendem acesso a ferramentas turnkey de falsificação e infraestrutura de fraude de identidade, reduzindo drasticamente a barreira de entrada para os invasores. Isso cria um efeito de concentração: ferramentas compartilhadas, ativos reutilizados e operadores sobrepostos tornam essas redes mais visíveis para análise de rede gráfica e visual, permitindo que defensores descubram relacionamentos e desmantelem anéis inteiros de fraude em vez de parar ataques individuais.

De acordo com uma análise recente por uma empresa de verificação de identidade, as tentativas de fraude cresceram 21% ano a ano, com uma em cada vinte tentativas de verificação agora sinalizada como fraude. Os invasores estão cada vez mais combinando deepfakes com phishing, engenharia social e apropriações de conta para sobrecarregar os controles tradicionais. É por isso que soluções como o Escilador do Oscilar de Identidade Cognitiva vão além de verificações estáticas, correlacionando comportamento, infraestrutura e sinais a nível de rede que identidades sintéticas — mesmo altamente realistas — não podem replicar consistentemente.

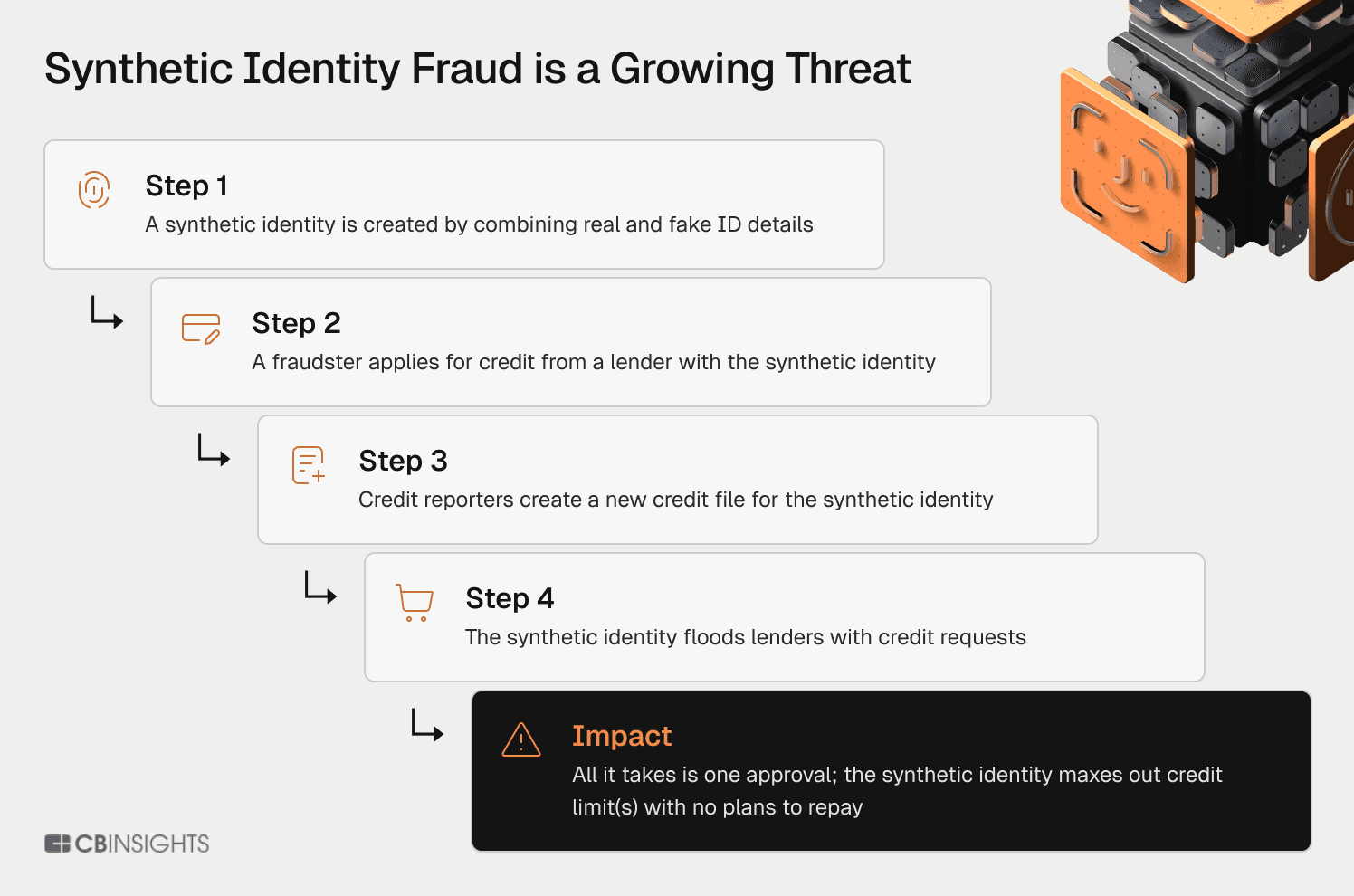

Por que é fraude de identidade sintética o "inimigo invisível"?

O Banco da Reserva Federal de Boston identifica a fraude de identidade sintética como o crime financeiro de crescimento mais rápido nos Estados Unidos, com perdas ultrapassando $35 bilhões em 2023. Ao contrário do roubo de identidade tradicional, a fraude sintética cria identidades "Frankenstein" combinando um número de Seguro Social legítimo (frequentemente de uma criança, idoso ou falecido) com nomes e datas de nascimento fabricados.

Essas personas fabricadas são incubadas por 12-24 meses. Fraudadores solicitam crédito, são rejeitados (o que cria um arquivo de crédito), então, gradualmente, constroem históricos de crédito impecáveis. Quando eles "estouram" — maximizando linhas de crédito e desaparecendo — a identidade sintética pode ter uma pontuação de crédito acima de 750. Nossa análise da AI gerativa na detecção de fraudes mostra que ataques de explosão usando identidades sintéticas representaram $2,9 bilhões apenas em empréstimos automotivos e cartões de crédito.

A Ferramenta de Mitigação de Fraude de Identidade Sintética da Reserva Federal revela a catástrofe contábil: essas perdas geralmente são classificadas como "perdas de crédito" (dívida incobrável) em vez de perdas de fraude. Os bancos acreditam que têm um problema de subscrição quando, na verdade, têm um problema de fraude, e essa classificação incorreta esconde bilhões das equipes de risco.

Mas identidades sintéticas representam apenas uma dimensão da crise de identidade. As instituições financeiras também enfrentam desafios persistentes de mulas de identidade — pessoas reais usando documentos genuínos que estabelecem contas antes dos fraudadores assumirem. Essas mulas podem passar nas verificações de documentos e selfies, especialmente quando recrutadas de países em desenvolvimento, onde o custo para comprometer um indivíduo é baixo.

Ao contrário dos sintéticos, as mulas deixam trilhas de papel limpas até o momento da tomada, tornando-as quase invisíveis para os controles tradicionais de integração.

Como os criminosos estão industrializando ataques de deep fake e identidades sintéticas?

O ataque à Arup não foi de um hacker solitário — foi o produto de uma cadeia de suprimentos industrializada. A dark web opera como um mercado maduro de "Fraude como Serviço". Serviços de geração de deepfake custam apenas $15 por vídeo. "Corretores de Acesso Inicial" vendem credenciais para redes comprometidas, enquanto "Provedores de Painel" oferecem botnets baseadas em assinatura que fazem ataques parecerem se originar de endereços residenciais legítimos.

A IA generativa acelerou a ameaça. A Reserva Federal adverte que GenAI age como "um acelerador" — automatizando a criação de identidade, aprendendo com falhas e otimizando quais perfis têm sucesso em instituições específicas. Como detalhado em nossa análise de agentes de IA na fraude e gestão de risco, esses agentes podem navegar em interfaces bancárias, resolver CAPTCHAs e executar milhares de microtransferências por meio de redes de mulas em segundos.

A verdade desconfortável: Você não pode resolver a fraude industrializada e habilitada por IA apenas com pessoal. As equipes de revisão manual se afogarão no volume.

Por que as defesas dos bancos continuam falhando?

As instituições financeiras organizam defesas em silos: equipes de KYC lidam com integração, equipes de fraude monitoram transações, equipes de AML observam lavagem, equipes de crédito gerenciam risco de inadimplência. Os invasores exploram as lacunas. Uma identidade sintética passa no KYC (os documentos parecem legítimos). O crédito aprova um empréstimo (a pontuação é excelente). A equipe de fraude sinaliza um dispositivo suspeito — mas como o usuário está "verificado" e com "crédito aprovado", o alerta é suprimido.

Essa abordagem em silos cria um paradoxo perverso. As equipes de risco e fraude, que veem a atividade fraudulenta como 100% de seu mundo, mesmo que represente 1-2% do comportamento real do usuário, frequentemente projetam fluxos e recursos de produtos pesados em fricção que frustram clientes legítimos. Enquanto isso, ataques genuinamente perigosos passam despercebidos porque as informações não fluem entre as camadas de defesa.

O desafio tem duas dimensões: organizacional e temporal. As instituições precisam distinguir entre a velocidade de detecção e a velocidade de ação. Detectar algo suspeito pode acontecer instantaneamente, mas a gravidade da fraude e o valor estratégico da observação (como usar honeypots para mapear redes de fraude) determina se a ação deve ser em tempo real ou deliberadamente atrasada. Uma compra de $50 pode ser concluída instantaneamente. Uma transação de relógio de luxo de $50,000? Tanto o comprador quanto o vendedor esperam a devida diligência.

A Gartner prevê que em 2026, 30% das empresas não confiarão mais em soluções de verificação de identidade autônomas. O modelo de KYC "uma vez e está feito" está fundamentalmente quebrado. É por isso que a abordagem AI agente da Oscilar se concentra na inteligência de risco contínua em vez de segurança baseada em pontos de verificação.

Enquanto isso, apenas 22% das instituições financeiras implementaram ferramentas de prevenção de fraude baseadas em IA, de acordo com a plataforma de identidade Signicat — uma lacuna perigosa quando os atacantes operam em velocidade de API enquanto os defensores trabalham em processos em lote. Quase 60% das empresas relataram aumento de perdas por fraude de 2024 a 2025.

Como é uma defesa eficaz em 2026?

Em 2026, a defesa eficaz depende menos de regras isoladas e mais de inteligência unificada. Isso significa juntar sinais de identidade, dispositivo, comportamento e transação em uma única estrutura de decisão em tempo real, para que o risco possa ser avaliado de forma holística em vez de fragmentado.

Defender-se contra deepfakes e fraudes modernas requer profundidade em quatro camadas interligadas:

Camada 1: Prevenção de Registro em Massa

Na camada mais externa, as equipes de risco trabalham com a infosec para detectar preenchimento de credenciais, criação de conta por bots e credenciais à venda após grandes vazamentos de dados. Isso impede ataques antes que alcancem fluxos de verificação legítimos.

Camada 2: Validação de Registro e Aplicação

Além de validar PII, controles eficazes nesta camada incluem verificação de emprego e renda para produtos de empréstimo. Para empréstimos pessoais, automotivos e hipotecas, essas verificações criam fricção proporcional ao risco — o que chamamos de fricção prudente, calibrada para a gravidade do evento e a precisão dos modelos de detecção.

Camada 3: Monitoramento Comportamental Pós-Registo

Após a criação de uma conta, o foco muda para detectar comportamentos suspeitos no momento da transação. Estouros de cartões de crédito aparecem em padrões de primeira compra. A fraude em transporte compartilhado manifesta-se em anomalias de localização, distância percorrida ou comportamento de direção. A fraude de mercado aparece como crescimento explosivo de vendedores ou táticas de atraso projetadas para fazer os compradores pensarem que itens estão em trânsito.

Camada 4: Defesa contra Apropriação de Conta

A engenharia social continua a ser o vetor primário para apropriação de contas. Monitoramento contínuo de comportamento de sessão, troca de dispositivos e padrões de comunicação podem detectar quando um titular legítimo de conta foi substituído por um fraudador.

Plataformas como o Oscilar são projetadas para apoiar essa abordagem em camadas oferecendo decisões em tempo real em fraude, crédito e conformidade usando sinais compartilhados e avaliação de baixa latência — para que as equipes possam responder rapidamente sem fragmentar suas defesas.

Prevenindo deepfakes através da superfície de ataque

Embora deepfakes possam parecer convincentes isoladamente, eles deixam para trás um rastro de migalhas de pão ao longo do ciclo de vida do dispositivo, sessão e aplicação.

Prevenir deepfakes na fonte começa com a análise do dispositivo e da interação usados para enviar um biométrico. Impressão digital do dispositivo, detecção de emulador e câmera virtual, e sinais comportamentais e cognitivos (como micro-tremores no manuseio do telefone ou padrões de hesitação sob pressão) podem expor interações sintéticas ou coagidas antes mesmo de um biométrico ser capturado.

Prevenir deepfakes na captura envolve alavancar análise de vivacidade e biométrica baseada em IA para avaliar se o que está sendo apresentado é realmente humano. Isso vai além de desafios estáticos ou determinísticos, analisando artefatos biométricos e dinâmicas de apresentação para inconsistências sutis que indicam manipulação ou síntese.

Prevenir deepfakes na submissão significa tratar a aplicação como uma entidade holística, e não como um único evento biométrico. Uma vez que os dados entram no sistema, o Oscilar correlaciona sinais através de atributos de identidade, documentos, dispositivos, redes e padrões comportamentais — revelando discrepâncias como uma correspondência facial de alta confiança emparelhada com um dispositivo anômalo, metadados do documento incompatíveis ou contexto de transação suspeito.

Combatendo identidades sintéticas com dados autoritativos

Para identidades sintéticas, o controle mais poderoso e fundamental continua sendo o serviço eCBSV da Administração da Previdência Social, validando se um SSN realmente corresponde aos dados de identidade declarados. Oscilar suporta eCBSV através de provedores de identidade confiáveis como a Socure, e enriquece esses resultados com análise de pegada digital mais ampla — idade do email, histórico da operadora de telefone, reutilização de dispositivo e associações de rede — permitindo que instituições financeiras diferenciem identidades fabricadas de candidatos legítimos e com arquivos finos enquanto descobrem padrões de fraude repetíveis em escala.

Modelos avançados de ML evoluíram além de previsões de instantâneos. Capacidades computacionais recentes agora permitem que plataformas combinem todos os dados do usuário ao longo de toda a jornada, fornecendo uma imagem holística que se mostra muito mais eficaz do que pontos de decisão isolados. Este modelo de inteligência contínua é o que separa as plataformas de risco modernas dos sistemas legados baseados em pontos de controle.

O que os líderes financeiros devem fazer agora?

O manual operacional para 2026 exige cinco ações imediatas:

1. Desmantelar os silos

Se sua equipe de fraude não pode ver o que sua equipe de KYC viu, você está cego para ataques convergentes. Quebre as barreiras organizacionais entre integração, transações, crédito e AML.

2. Audite seu "balde de perdas de crédito"

Identifique quanto da dívida incobrável é, na verdade, fraude sintética disfarçada. Reclassificar essas perdas corretamente liberará orçamento e urgência para defesas adequadas.

3. Proteja o tubo da câmera

Implemente a detecção de ataques de injeção e trate cada feed de vídeo como não confiável até ser verificado criptograficamente. O biométrico em si pode ser perfeito — mas se o mecanismo de entrega estiver comprometido, a verificação é inútil.

4. Implemente agentes de defesa habilitados por IA

Capacidades de investigação autônoma que escalam com ataques automatizados. Esses agentes podem decidir se a atividade é boa ou ruim, solicitar informações adicionais e identificar casos semelhantes em filas de revisão — permitindo que analistas humanos trabalhem uma ordem de magnitude mais rápido.

5. Mude da segurança de porteiro para monitoramento contínuo

A confiança deve ser reconquistada a cada sessão, a cada transação. O termo emergente na indústria é KYX (Conheça sua Experiência), substituindo KYC de uma vez só por garantia persistente ao longo do ciclo de vida do cliente.

A pressão regulatória e de normas está aumentando. As regras de 2026 da NACHA exigem detecção de fraudes "comercialmente razoável" para entradas de débito na web. Em vigor até agosto de 2026, a Lei de IA da UE exige rotulagem clara de deepfakes e controles de transparência. Os compradores devem avaliar se seus fornecedores estão enfrentando de frente os padrões técnicos emergentes, como CEN/TS 18099, que aborda especificamente ataques de injeção de dados biométricos.

Como iniciativas como o Protocolo de Agente Confiável da Visa demonstram, o futuro da confiança depende da verificação criptográfica de cada ator e de cada fluxo de dados em toda a cadeia de transação.

Construindo uma nova infraestrutura para confiança

O roubo de $25,6 milhões na Arup demonstrou uma nova realidade brutal: quando você não pode confiar nos seus olhos e ouvidos, deve confiar nos seus dados. A convergência de identidades sintéticas, injeção de deepfake e automação agentica tornou obsoletas as arquiteturas de segurança legadas.

A tecnologia para fabricar a realidade já existe. A única defesa é um sistema que vê os padrões invisíveis por trás da fabricação — unificado, cognitivo e operando em velocidade de máquina. Plataformas como o Oscilar estão construindo essa nova infraestrutura de confiança, combinando decisão de risco baseada em IA com inteligência de identidade cognitiva para detectar fraudes em tempo real.

Mas o futuro também exige repensar a relação fundamental entre identidade, intenção e consequência. Em uma era onde agentes de IA podem realizar transações em nome dos usuários, muitos clientes legítimos priorizarão a privacidade e conveniência sobre a divulgação explícita de identidade. O desafio para os gerentes de risco não é exigir identificação perfeita em cada ponto de contato, mas calibrar a resposta ao risco com base na gravidade da consequência e na confiança do modelo de detecção.

Isso vai além da prevenção de perdas. O que está em jogo é a base da economia digital: a própria confiança.